Webサイトのサイトマップには、二種類あります。

- 訪問者(人間)が見るもの

- 検索ロボットが見るもの

今回は、後者の検索ロボット用のサイトマップの話です。これを用意することで、検索ロボットが効率よくサイト内を巡回し、結果、インデックスされやすくなる(だろう)という効果があります。

これにもプラグインを使います。たくさんあるみたいですが、有名なものを使っておきます。こういうのは無難なのが一番です。

Google XML Sitemaps

プラグインの新規インストール画面で、上記名前で検索すれば見つかります。インストールと有効化はいつも通りです。

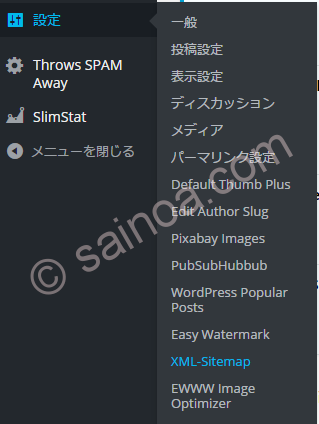

では、設定です。と言っても、標準のままでOKです。でも、まぁ、一応見ておきましょう。サイドバーの「設定」→「XML-Sitemap」です。メニュー上はGoogle XML Sitemapsという名前ではない点に注意。

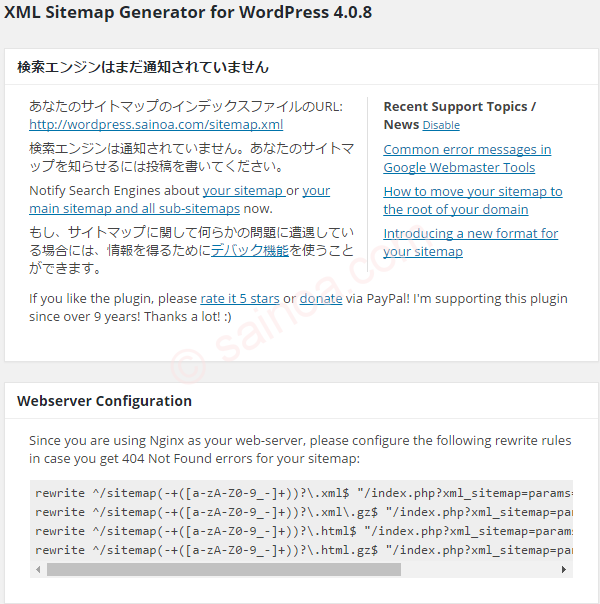

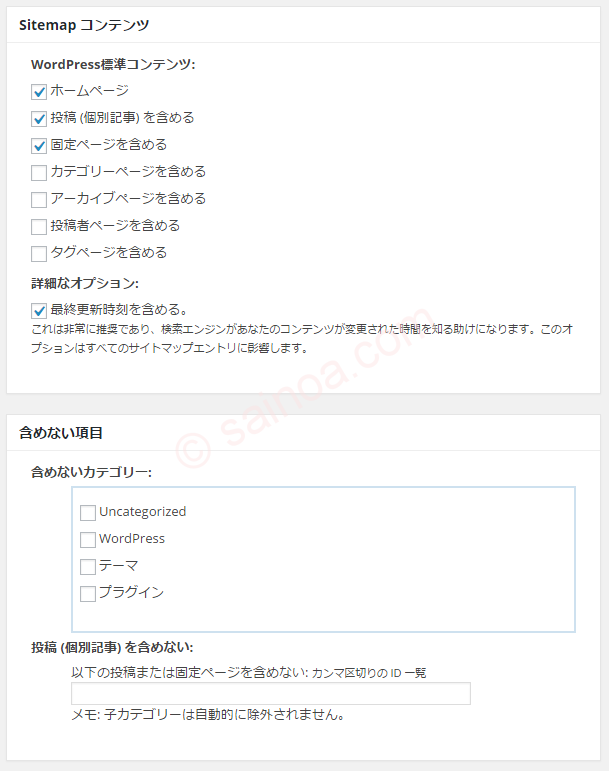

設定画面はこんな感じ。

今インストールしたばかりなので、まだ検索エンジンには通知されていません。記事を投稿すれば、自動で通知がなされます。ちなみに、ここに記載されているサイトマップのリンクをクリックすれば、実際のサイトマップを見ることができます。

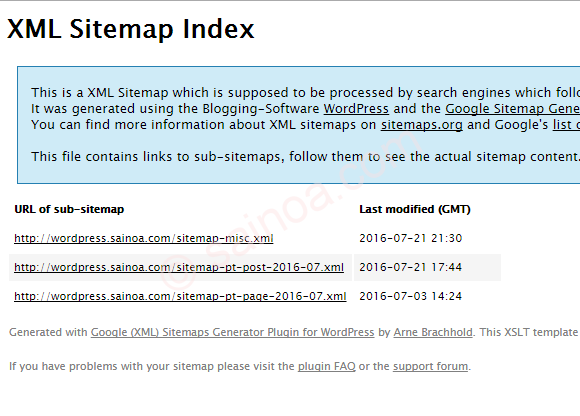

このプラグインで生成されるサイトマップはいくつかのサブベージに分割されており、ここからさらにリンクしています。興味があれば、リンクをたどってみてください。全部を見る必要もないですが、一度はチェックしておくと、ちゃんと生成されていることがわかり安心です。

設定画面に戻ります。

ここで一つ注意。

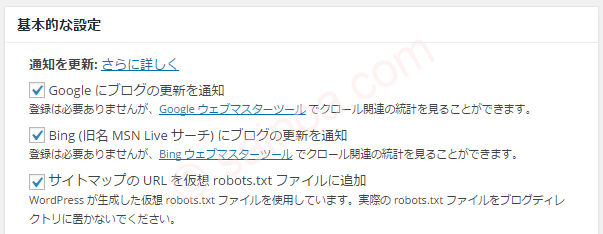

サイトマップのURLを仮想robots.txtファイルに追加

とあります。これについて少々説明しておきます。

WordPressではrobots.txtファイルが存在していなければ、仮想的に生成します。どういうことかというと、ファイルの実態がなくても、そのファイルをアクセスすると、その場で動的に自動生成するのです。

WordPressの記事自体が自動生成ですよね。実際には記事はHTMLファイルとして存在するわけではなく、アクセスされたときにデータベースから情報を引っ張ってきてHTMLを作ってWebブラウザに渡します。

それと同じように、robots.txtも自動生成するわけです。その際、サイトマップの情報をrobots.txtに入れる、というのが上のチェックです。

ですが、Z.com for WordPressの場合、robots.txtが標準で作られています。「robots.txtが存在しなければ自動生成」ですので、ここのチェックは無効です。

説明文は、

WordPress が生成した仮想 robots.txt ファイルを使用しています。実際の robots.txt ファイルをブログディレクトリに置かないでください。

と、なんだか変ですが、正しい解釈は上のとおりです。

結果、robots.txtには、サイトマップ情報が置かれませんが、検索ロボットにサイトマップ情報を伝える手立ては他にもあるので、実害はないでしょう。気になるなら、標準で付いているrobots.txtを削除するか、あるいは、逆にrobots.txtにサイトマップ情報を書き加えるかです。いずれの場合も、ftpを使えば可能です。

その下には、サイトマップにどの情報を含めるか、逆に含めない記事の指定などがあります。

例えば、運営者情報やプライバシポリシなどをサイトマップに含めたくなければ、ここで指定しておきます。

内容を編集した場合には、最後の「設定を更新」を忘れずに。

人間用のサイトマップの作り方はこちら。